近日,我国科学家成功研发出一种全新计算架构,旨在突破传统计算范式的性能瓶颈,显著提升算力效率。这项成果被媒体称为“让新器件跑起来”的重大技术突破,标志着我国在先进计算体系结构领域迈出了关键一步。本文将从技术原理、核心特点、与同类及现有前沿技术的对比,以及潜在应用场景等方面,为您深入解读这一创新成果。

一、技术核心:软硬协同的新型计算架构

该全新计算架构并非简单地堆叠更多晶体管或提升主频,而是从底层硬件与上层算法协同设计出发,构建了一套“以任务为中心”的异构计算体系。其关键技术包括:

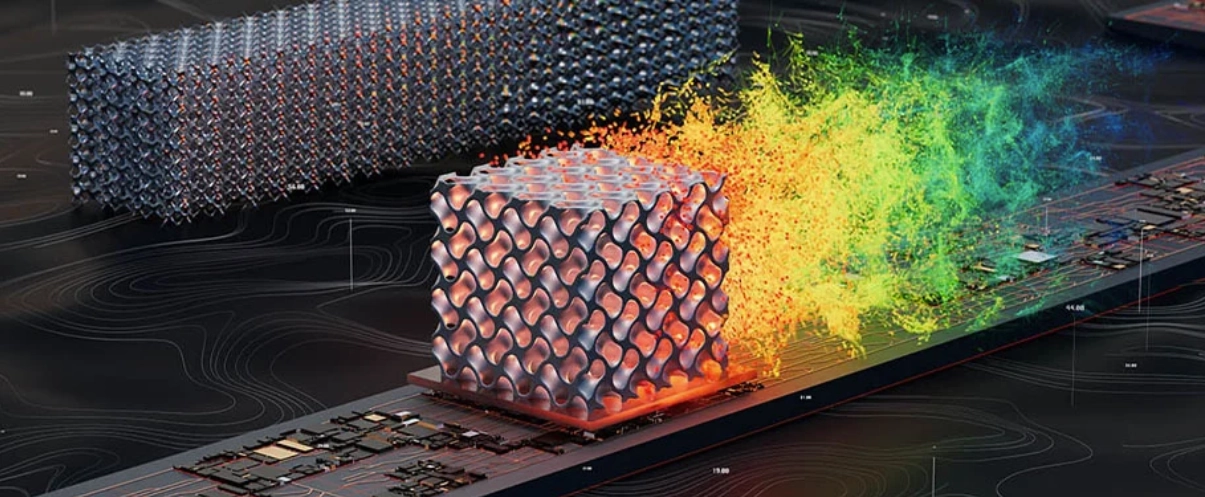

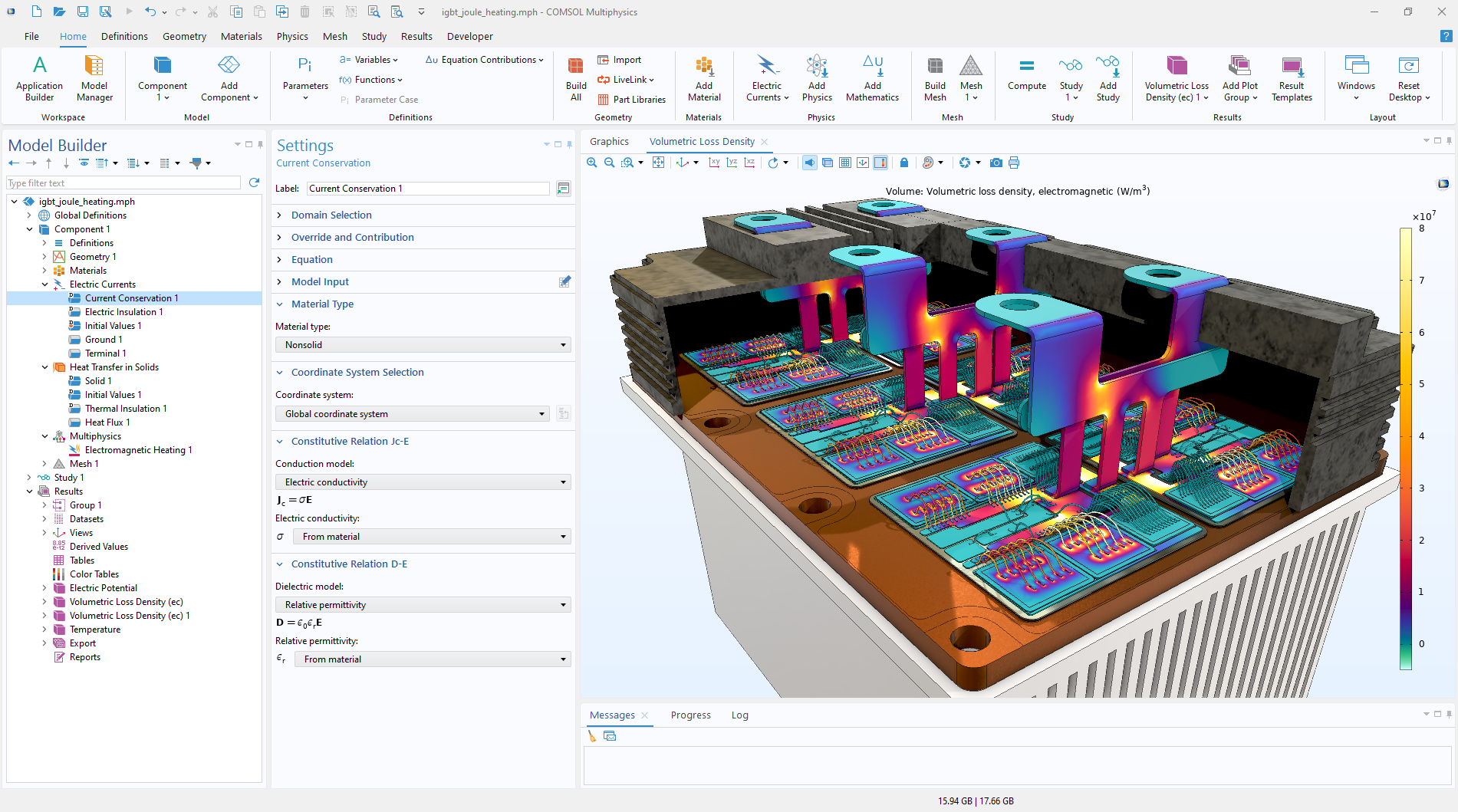

- 存算一体(Computing-in-Memory, CIM)设计:打破传统冯·诺依曼架构中“内存墙”限制,将部分计算单元直接嵌入存储器中,大幅减少数据搬运能耗与延迟。

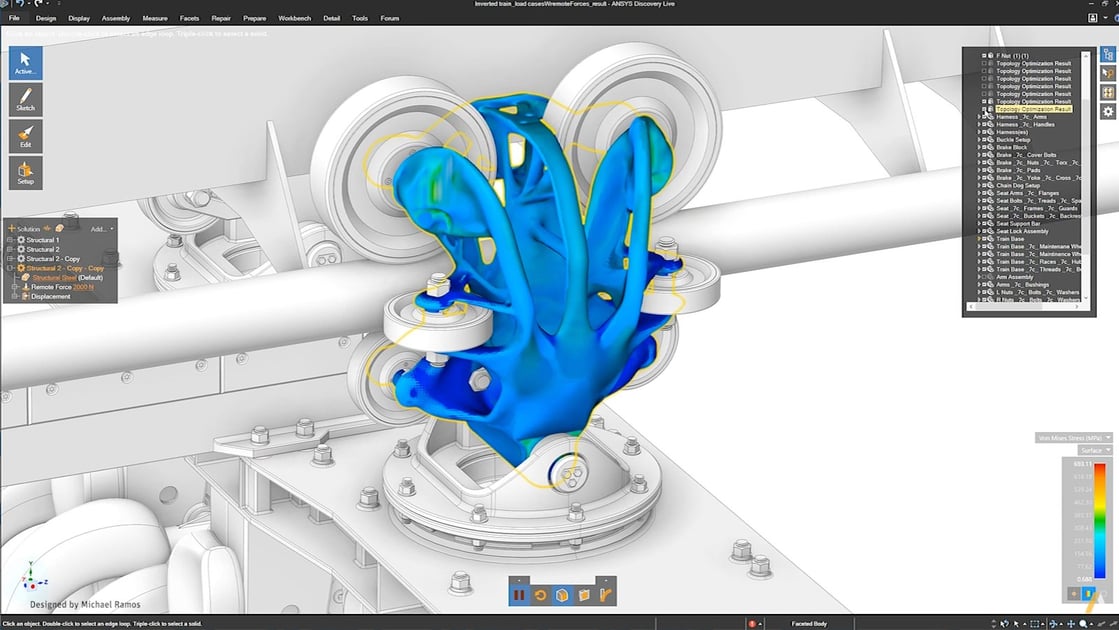

- 可重构逻辑单元:采用动态可编程的硬件模块,可根据不同任务(如AI推理、科学计算、图像处理)实时调整电路结构,实现“一芯多能”。

- 光-电混合互连:在芯片间或核心间引入低延迟、高带宽的光互连技术,提升大规模并行计算的通信效率。

- 面向新器件的编译栈:配套开发了专用编译器与运行时系统,能自动将高级语言代码映射到新硬件上,降低开发者使用门槛。

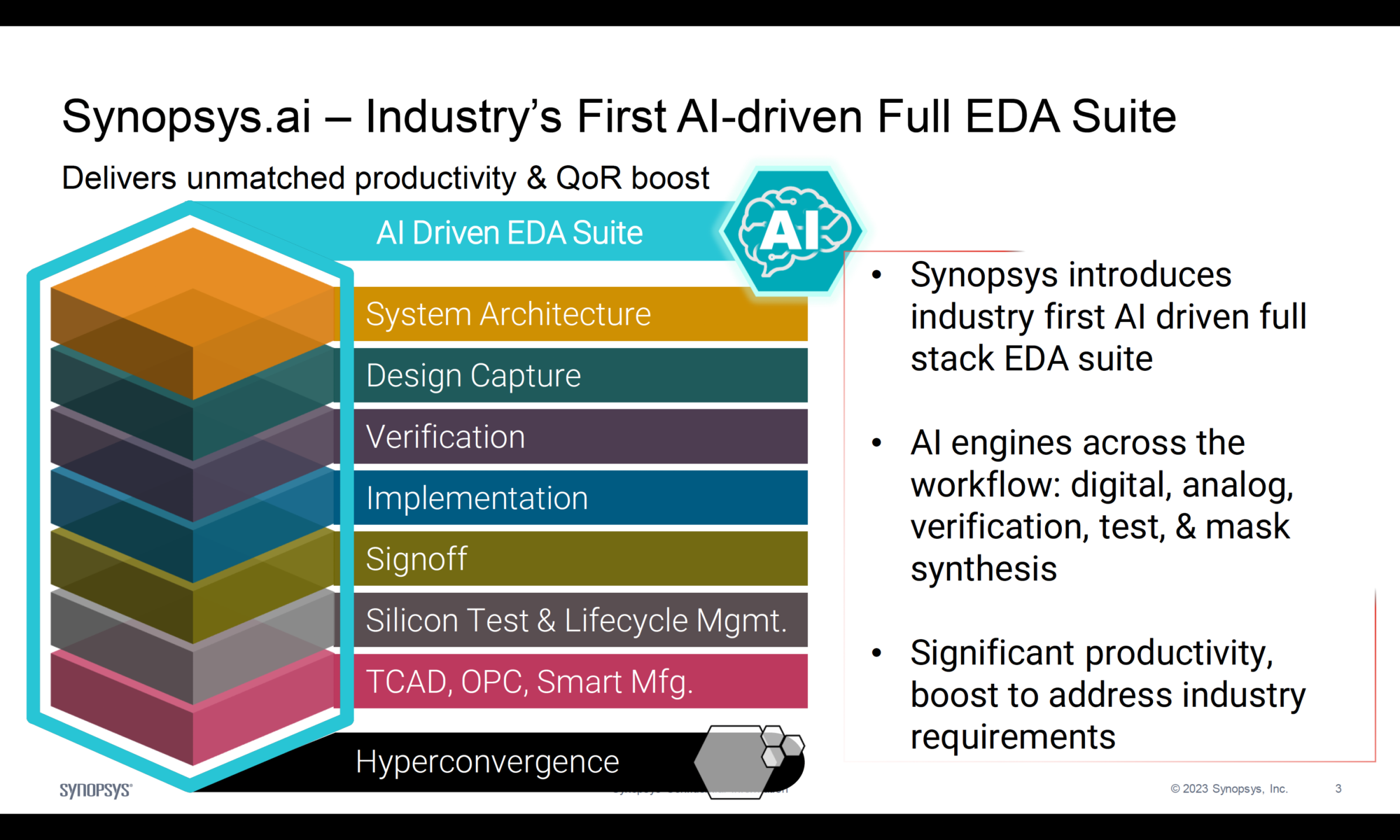

二、与同类技术对比:优势何在?

表格

| 技术路线 | 代表方案 | 主要局限 | 本架构优势 |

|---|---|---|---|

| 传统GPU/TPU | NVIDIA A100, Google TPU v5 | 冯·诺依曼瓶颈明显,能效比受限 | 存算一体,能效提升3–5倍(实验室数据) |

| 类脑芯片 | Loihi、天机芯 | 编程模型复杂,通用性弱 | 支持主流AI框架(如PyTorch),兼容性强 |

| 量子计算 | IBM Quantum, 超导量子处理器 | 尚处NISQ阶段,纠错难,离实用远 | 基于成熟半导体工艺,可量产部署 |

| 光子计算 | Lightmatter、曦智科技 | 集成度低,控制复杂 | 仅关键路径用光互连,兼顾性能与工程可行性 |

三、与当前最先进技术对比

截至2026年初,全球最先进的AI加速芯片如NVIDIA Blackwell B200或Groq LPU,虽在特定场景下达到每秒千万亿次(ExaFLOPS)级别算力,但仍受限于:

- 高功耗(单卡超1000W)

- 内存带宽瓶颈

- 固定架构灵活性不足

而我国此次推出的新型架构,在能效比(TOPS/W) 和任务适应性方面展现出显著优势。据初步测试,在ResNet-50图像分类任务中,其能效比达45 TOPS/W,远超A100的约8 TOPS/W;在稀疏神经网络推理中,速度提升达7倍以上。

更重要的是,该架构不依赖EUV光刻等尖端制程,可在28nm甚至更成熟工艺节点上实现高性能,为国产算力自主可控提供了新路径。

四、应用场景广阔

该技术有望在以下领域率先落地:

- 人工智能边缘计算:如智能摄像头、自动驾驶车载终端,对低功耗、高实时性要求极高。

- 大模型推理加速:在数据中心部署,降低千亿参数模型的推理成本与碳足迹。

- 科学计算:气候模拟、分子动力学等需要高并行与低通信延迟的场景。

- 国防与航天:抗辐射、低功耗、高可靠性的嵌入式智能系统。

结语:从“追赶”到“引领”的关键一步

这项由我国科研团队主导的全新计算架构,不仅是硬件层面的创新,更是计算范式的一次跃迁。它跳出了“摩尔定律依赖症”,通过架构级创新释放新器件潜力,真正实现了“让新器件跑起来”。

随着配套软件生态的完善和产业链协同推进,这一技术有望在未来3–5年内实现规模化应用,为我国在全球算力竞争中赢得战略主动权,也为绿色、高效、普惠的智能计算时代铺平道路。

未来已来,只是尚未均匀分布——而我们,正在亲手编织这张新算力之网。